Видеокарты

Подписаться на эту рубрику по RSS

Ускорение в среднем весе. Тестируем Radeon HD 7790 и GeForce GTX 650 Ti Boost на платформе AMD.

Рубрика: ВидеокартыМетки: GeForce GTX 650 Ti | GeForce GTX 650 Ti BOOST | Radeon HD 7790 | Radeon HD 7850 | обзор | разгон | тестирование

Дата: 10/04/2013 16:50:43

Аналитика. Фирменные технологии и инициативы.

Удивительно, но необычно холодная весенняя погода никак не отразилась на способностях наших любимых AMD и NVIDIA к выпуску “горячих” новинок. Сначала NVIDIA и AMD ударили по рынку Hi-End. Зелёные через своих партнёров начали продажи эталонных версий GeForce GTX TITAN, а AMD, в свою очередь, с гордостью смотрела на величественное шествие ускорителя ASUS ARES II, демонстрирующего невероятную мощь пары GPU Tahiti XT вкупе с высочайшим качеством исполнения самой платы и её системы охлаждения. Каждое из этих решений, пожалуй, имеет свои плюсы и свои недостатки, но в целом, поставленные перед инженерами цели были достигнуты. Ускоритель GeForce GTX TITAN построен на основе самого мощного в мире GPU, в то время как ASUS ARES II является, пожалуй, самым производительным графическим ускорителем на момент написания этих строк. И вот, после небольшой передышки, театр боевых действий в который раз сместился. Теперь всё внимание маркетологов и инженеров обеих компаний обращено к более скромным решениям, которые, несмотря на свою “скромность” как раз приносят им основной доход. Первый залп был за AMD. Менее чем за сутки до анонса Radeon HD 7790 несколько журналистов были приглашены в московский офис AMD, где после подписания документов о неразглашении, нам были показаны слайды, демонстрирующие все возможности новых GPU компании. Спустя несколько дней пришла добрая весточка и от NVIDIA – мы увидели характеристики GeForce GTX 650 Ti BOOST – прямого конкурента Radeon HD 7790. Что тут скажешь? Молодцы. И те и другие. Меня искренне радуют такие вот конкурентные баталии, поскольку в них, не на словах, а наделе проявляются все сильные и слабые стороны участников. Чем хороши новинки, каковы их характеристики и возможности, мы узнаем чуть позже, а пока, мой нетерпеливый читатель, перед тем, как я представлю свою версию подсчёта fps “По Чурову” (шутка-петросянка), хочу рассказать ещё кое о чём. Дело в том, что оба наших графических исполина ведут бои за покупателя не только при помощи классического оружия в виде видеокарт. И AMD и NVIDIA прикладывают свои усилия по взаимодействию с пользователями через игры и инструменты для игр. Приведу примеры. Начну по порядку.

Совсем недавно компанию AMD ругали за то, что она мало сотрудничает с разработчиками игр, которые, в свою очередь, при каждом удобном случае демонстрируют логотип “NVIDIA. The way it’s meant to be played”. Создавалось впечатление, что с разработчиками игр сотрудничает только NVIDIA, что, разумеется, было не так. В компании прислушались. И вот, во многих современных играх я вижу логотип “AMD Gaming Evolved”. Не буду утверждать насколько глубоко такое сотрудничество в плане инженерном, радует сам факт, что отныне светится не только NVIDIA. Кроме того, в рамках AMD Gaming Evolved проводится акция под названием “Never Settle / Never Settle Reloaded”. Суть проста. Покупаешь видеокарту(ы) AMD - получаешь лицензионную игру или даже игры в подарок. Как участник этой инициативы, скажу, что компания предлагает актуальные игры из ТОП-10 игровой индустрии, что весьма ценно.

Не осталась в стороне и компания NVIDIA. Чтобы далеко не уходить от предыдущего абзаца, скажу, что ответом на Never Settle Reloaded стала маркетинговая акция “зелёных” под названием “Gear Up. Load Up. Game On”. По условиям этой акции покупатели GeForce GTX 650 (Ti) и GeForce GTX 660, а также старших моделей GeForce могли получить бонусы в виде игровой валюты в ряде популярных онлайн игр, например World of Tanks. К сожалению, я не участвовал, так что за подробностями сюда. Ещё одной фишкой от NVIDIA стала технология GeForce Experience. Эта технология будет интересна, прежде всего, людям не сильно замороченным на тонкой настройке графических параметров игр, проще говоря, обычным пользователям. Суть GeForce Experience в том, чтобы минимизировать количество действий, нужных для достижения баланса между производительностью и качеством картинки для данной конфигурации ПК, GFE – это своего рода попытка превратить ПК в консоль с точки зрения простоты настройки. По словам NVIDIA, при подборе оптимальных параметров используются данные о центральном процессоре, графическом ускорителе и используемом разрешении монитора. Все эти данные передаются в облако, после их обработки вы получаете ответ на вопрос “Как сделать быстро и красиво”. Позволю себе процитировать данные, полученные от российского представительства компании:

Как определяются оптимальные настройки? Это сочетание ручного и автоматизированного тестирования:

- - Специалисты NVIDIA проходят игры, чтобы составить общее впечатление об игре

- - Определяют наиболее сложные сцены (не max сложности, где-то 80%).

- - Назначается комфортный порог играбельности - ориентируемся на вилку 40-60 кадров в секунду ( в зависимости от типа игры: для стратегий ~40, для шутеров >60).

- - Далее вручную проверяют, как те или иные графические настройки влияют на качество картинки и производительность. Каждой настройке присваивается определенный вес

- - Далее все загружаются в суперкомпьютер, который определяет оптимальную комбинацию графических настроек с учетом достижения наилучшего кач-ва картинки при заданном fps

- - Для каждой игры проверяется масса конфигураций GPU + CPU + разрешение дисплея и составляются таблицы с оптимальными настройками. Конечная цель GFE – обеспечить максимальное качество картинки при заданном fps на конкретной конфигурации ПК

- Получить настройки можно только для тех игр, которые были протестированы NVIDIA. Вот их текущий список (55 штук) - http://www.geforce.com/drivers/geforce-experience/supported-games

- - Когда тебе приходят настройки, ты можешь их принять или отказаться. Без разрешения геймера, никто ничего оптимизировать в игре не будет. За геймером всегда остается право выбора.

На словах, разумеется, всё выглядит красиво. Вошёл в программу, нажал кнопку и получил результат. Я решил проверить GeForce Experience на практике, для этого я использовал следующую конфигурацию:

- Intel Core i7 980X

- ASUS Rampage III Black Edition

- 16 Гбайт DDR-3 AMD Performance memory

- ZOTAC GeForce GTX 680 AMP!

- 2x 1 Тбайт Seagate ES.2 RAID0

- Microsoft Windows 8 Professional

Скачал клиент GFE, установил его и запустил. После того, как закончился анализ конфигурации и был найден список поддерживаемых игр, я начал изучать разделы с текущими и оптимальными с точки зрения NVIDIA параметрами. Для того, чтобы GFE клиент смог определить текущие настройки, игра должна быть хоть раз запущена, поскольку программа берёт настройки игры из её файла конфигурации, а значит, если он пуст, то и брать нечего.

Всё вроде бы верно, GFE нашёл на моём ПК несколько игр, для некоторых из них, Bioshock Infinite, например, были успешно определены текущие настройки и успешно установлены оптимальные, для других же, например Far Cry 3, не всё оказалось так просто. Несмотря на неоднократный запуск игры и наличие её в списке найденных, клиент GeForce Experience не видел текущих настроек игры и, что вполне логично, несмотря на наличие оптимального графического профиля, отказывался его применять.

Перезапуск GFE, системы, а также многократный вход и выход из игры с переменой внутренних настроек графики, результатов не принёс. Уверен, что все текущие проблемы со временем будут устранены, однако пока рассматривать GeForce Experience в качестве волшебной пилюли, делающей мир вокруг прекрасным, не стоит.Тем не менее, GFE в некоторых случаях полезен. Помимо функции оптимизации игровых настроек, присутствует вкладка, через которую можно контролировать состояние драйверов и держать их в актуальном состоянии.

На мой взгляд, эта утилита скорее приятное дополнение, позволяющее без лишней возни запускать некоторые современные игры, а для остальных всё ещё придётся всё ковырять руками. Кому интересно, могут почитать FAQ, и попробовать в деле клиент GFE, ну а я, наконец, перехожу к описанию видеокарт Radeon HD 7790 и GeForce GTX 650 Ti BOOST, ради которых, ты, дорогой читатель, перешёл по ссылке на эту статью.

Sapphire Radeon HD 7790. Позиционирование, упаковка, технические особенности.

Не секрет, что заклятый конкурент AMD, компания NVIDIA выпускает массу решений на базе архитектуры Kepler, причём не только самых дорогих, но и относительно дешёвых. Как известно, эти самые недорогие решения пользуются среди нас с вами максимальным спросом. В качестве примера возьмём видеокарты GeForce GTX 650 Ti. Эти продукты вполне можно считать сбалансированным и достаточно удачным выбором для недорогого игрового ПК. В разрешении 1680x1050 и 1920x1080 эти платы показывают приличную производительность при сохранении приличной детализации. У AMD, замечу, тоже есть такие продукты, однако до недавнего времени, прямого ответа на GeForce GTX 650 Ti у компании не было. И вот, наконец, свет увидел Radeon HD 7790, который и стал тем самым прямым ответом на GTX 650 Ti. Более того, несмотря на выход GeForce GTX 650 Ti BOOST, маркетинговый расчёт AMD никак нельзя считать промахом, поскольку обычный GeForce GTX 650 Ti с прилавков никуда не уходит, да и стоит новый GTX 650 Ti BOOST примерно на 1000 рублей дороже, чем HD 7790. Так что, прямым конкурентом для Radeon HD 7790 нужно считать GeForce GTX 650 Ti без приставки BOOST!

Теперь о самой AMD Radeon HD 7790. Чтобы не повторяться несколько раз и не описывать те изменения, которые внесла AMD в архитектуру GPU, на котором построен данный ускоритель, я дам ссылочку на новость, опубликованную в день его анонса. Там вы найдёте данные о количестве активных функциональных блоков, тактовых частотах ядра и памяти, а также об изменениях в системе энергосбережения GPU Radeon HD 7790. Я же хочу представить вам Sapphire Radeon HD 7790 Dual-X 1 Гбайт.

Упакована плата в небольшую картонную коробку, все грани которой, особенно лицевая и обратная сторона, отданы под описание возможностей ускорителя HD 7790. Производитель сообщает нам о том, что карта разогнана, на ней установлен 1 Гбайт видеопамяти и крутая система охлаждения. Кроме того, множество пиктограмм рассказывают нам о прочих передовых технологиях, вроде 28-нм технологического процесса для GPU, поддержки PCI-Express 3.0 и так далее.

Как и ожидалось, сама видеокарта и прилагаемые к ней аксессуары тщательно упакованы и аккуратно разложены внутри коробки, с транспортировкой по морям и океанам проблем наверняка не возникнет.

Помимо самой видеокарты Radeon HD 7790, в комплекте удалось обнаружить:

- Кабель HDMI длиной 1,8 м

- Переходник с DVI на VGA

- Гибкий CrossFire мостик

- Компакт диск с драйверами

- Набор бумажных инструкций и реклама

- Фирменная наклейка Sapphire

На мой взгляд, комплект очень достойный. Есть всё,что необходимо и даже немного больше. HDMI кабель будет полезен многим, например мне.

Снимаю полупрозрачную наклейку с кулера Sapphire Radeon HD 7790 Dual-X, карта предстаёт во всей своей красе. Дизайн системы охлаждения, как мне кажется, чем-то напоминает современный дизайн некоторых решений ASUS, обратите внимание на “срезанные” углы и общий стиль исполнения аля-Stealth. В общем, красиво.

На панели выводов четыре разъёма – на любой вкус, так сказать. Пара DVI(SL и DL), HDMI и полноразмерный выход DisplayPort. Считаю такой набор выходов самым оптимальным. Учитывая, что в комплекте идёт HDMI кабель и переходник DVI-VGA, всё становится ещё лучше. Если совсем обнаглеть, то остаётся ещё желать поставки с DP кабелем….

Ладно, пора играть на раздевание… Снимаем систему охлаждения. Её демонтаж занимает порядка 20 секунд, поскольку вся конструкция держится на четырёх подпружиненных винтах. Сама система охлаждения выглядит очень достойно. С графическим процессором контактирует медная подошва, которую пронизывают две толстенные тепловые трубки, переносящие тепло на рёбра радиатора. Чипы видеопамяти, прошу заметить, контактируют с алюминиевой подложкой, зажимающей тепловые трубки и контактирующей, отчасти, с рёбрами системы охлаждения. Контакт осуществляется через специальные термопрокладки. Общее количество чипов видеопамяти – 4 шт.. Пара вентиляторов подключаются к общему разъёму, размещённому на печатной плате Sapphire Radeon HD 7790 Dual-X.

А вот разводка PCB оставляет непонятное впечатление, сродни тому, которое появляется, когда в большом ресторане ты арендуешь лишь небольшой закуток, а всё остальное место остаётся “не для тебя”. Так и тут, основная часть PCB занята элементами поверхностного монтажа, местами установленными достаточно плотно, а вот хвост видеокарты пуст. Мне кажется, что для производства Radeon HD 7790 просто используется ранее созданная и уже использованная заготовка. Впрочем, плата не слишком велика. Это конечно не HTPC формат, однако в большинстве случаев владелец Sapphire Radeon HD 7790 во время установки дискомфорта не испытает. Приятной особенностью платы является наличие защитной пластиковой рамки вокруг кристалла GPU. По спецификации AMD графический процессор работает на частоте 1000 МГц, видеопамять на эффективной частоте 6000 МГц. Инженеры Sapphire немного разогнали свою версию 7790, её частотная формула составила 1075/6400 МГц для графического ядра и видеопамяти соответственно.

На этом внешний осмотр Sapphire Radeon HD 7790 закончен. Перехожу к описанию особенностей GeForce GTX 650 Ti BOOST.

NVIDIA GeForce GTX 650 Ti BOOST

Поскольку я ещё не вёл подробных бесед на тему архитектуры и позиционирования GeForce GTX 650 Ti BOOST, придётся сделать это прямо сейчас. Сначала о позиционировании. Как известно, GeForce GTX 650 Ti BOOST вышел практически сразу за Radeon HD 7790, однако, вопреки ожиданиям многих, новый средневес от NVIDIA не является прямым конкурентом Radeon HD 7790, поскольку его стоимость примерно на 1000 рублей выше (в главе, посвящённой Radeon HD 7790, я уже об этом писал). А вот следующий по счёту за HD 7790 ускоритель - AMD Radeon HD 7850 как мне кажется, вполне может быть конкурентом “BOOST’ированного” GTX 650 Ti, поскольку стоимость этих ускорителей, хоть и с натяжкой, но достаточно близка.

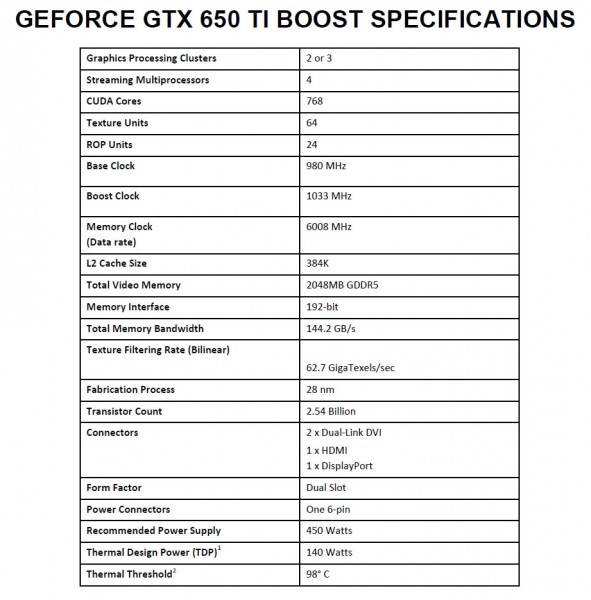

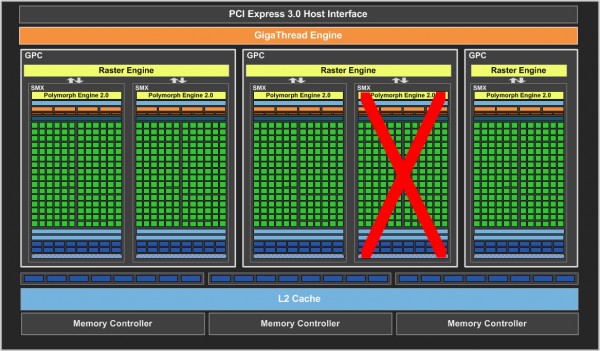

Теперь давайте разбираться с архитектурой GeForce GTX 650 Ti BOOST. Перед вами сводная таблица с основными спецификациями GeForce GTX 650 Ti, 650 Ti BOOST и 660 без приставки Ti.

|

Спецификации графических ускорителей серии GeForce GTX 650 Ti, 650 Ti BOOST и 660 |

|||

|

|

GTX 660 (GK106) |

GTX 650 Ti BOOST (GK106) |

GTX 650 Ti (GK106) |

|

Базовая частота ядра, МГц |

980 |

980 |

925 |

|

Турбо частота ядра, МГц |

1033 |

1033 |

-/- |

|

Ядра CUDA, шт |

960 |

768 |

768 |

|

Текстурные модули, шт. |

80 |

64 |

64 |

|

Блоки растеризации, шт. |

24 |

24 |

16 |

|

Эффективная частота видеопамяти, МГц |

6008 |

6008 |

5400 |

|

Ширина шины памяти, бит |

192 |

192 |

128 |

|

Объём видеопамяти, Мбайт |

2 |

2 |

1 или 2 |

|

ПСП видеопамяти, Гбайт/сек |

144,2 |

144,2 |

86.4 |

|

Скорость выборки текстур, гигатекселей в секунду |

78,4 |

62,7 |

59,2 |

|

TDP |

140 |

140 |

110 |

А также скриншот из официальной документации NVIDIA для обозревателей:

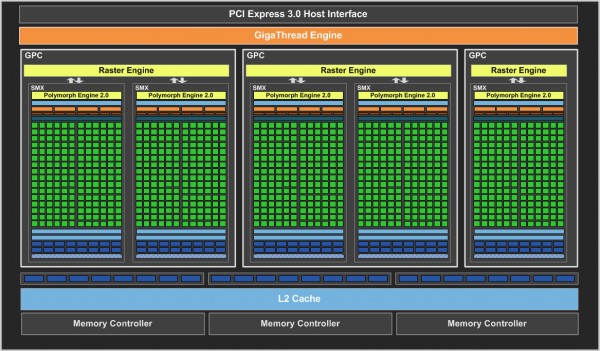

Так вот, согласно этим данным, лежащий в основе GeForce GTX 650 Ti BOOST чип GK106 может быть упрощён относительно полноценной версии этого GPU двумя способами. Первый – полное отключение одного из трёх GPC. При таком раскладе мы получаем классическую пару GPC, абсолютно симметричную по своему устройству.

Полная версия GK106

GK106 без одного GPC

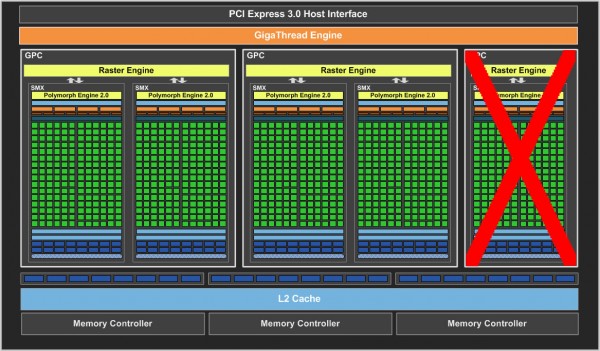

Второй вариант подразумевает исключение из состава любого GPC одного блока SMX. При таком раскладе у нас останутся активными все три GPC, однако один из них будет нести два блока SMX, а два других – по одному.

GK106 с отключенным SMX, при всех активных GPC

Однозначно сказать какой из вариантов лучше вряд ли возможно, более того, я думаю, что разницу между парой по-разному усечённых GPU мы вряд ли заметим даже в точных бенчмарках. Поправьте, если ошибаюсь. Так вот, если рассматривать устройство GTX 650 Ti BOOST в сравнении с младшим и старшим аналогом, то по своим характеристикам GeForce GTX 650 Ti BOOST больше тяготеет к GTX 660, нежели к GTX 650 Ti. Так почему же новинка выпущена под номером 650 Ti, а не 660? Скорее всего, причины исключительно маркетинговые. Ускоренные карты продаются куда лучше, чем замедленные. Чисто с психологической точки зрения приятно осознавать, что у тебя ускоренные GTX 650 Ti, близкий по производительности к GTX 660, нежели замедленный GTX 660, близкий к GTX 650 Ti. Во как! Уже чувствую, как жадные до денег торговцы будут пользоваться неведением новичков, осуществляя разные хитрости поигрывая с приставкой BOOST себе во благо. Впрочем, это не проблема NVIDIA. И не наша. Давайте уже посмотрим на саму карточку.

Про упаковку и комплектацию, в этот раз, не скажу ни слова. Плата, которая приехала к нам в тестовую лабораторию, является эталонным образцом и поступила непосредственно из российского представительства компании NVIDIA.

Честно скажу, я в последнее время очень впечатлён внешним видом ускорителей NVIDIA. Что GeForce GTX 690, что GeForce GTX TITAN выглядят великолепно. Промышленный дизайн, скажу я вам, тоже искусство, тому на рынке масса примеров. Эталонная версия GeForce GTX 650 Ti BOOST также выглядит весьма достойно, конечно, не так как TITAN, но всё же, перед “пацанами” не стыдно.

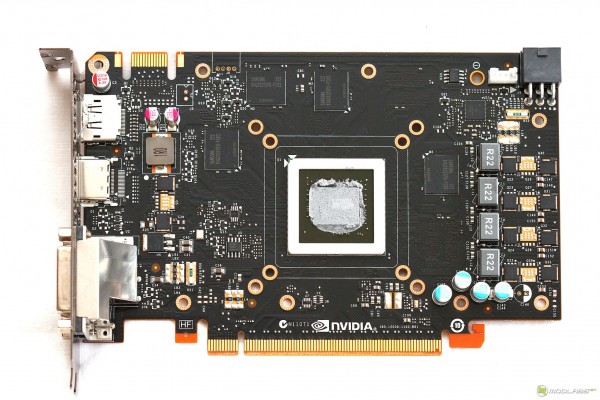

Кожух системы охлаждения целиком выполнен из пластика, рельеф которого сильно напоминает рисунок брони и заклёпки на ней. И всё бы ничего, если не глядеть на плату с обратной стороны. Ситуация очень похожа на случай с Sapphire Radeon HD 7790, только здесь сама плата очень коротка, а размера плате прибавляет турбина системы охлаждения, которая всеми своими движущимися частями находится за пределами печатной платы.

Панель выводов по своей структуре сильно напоминает оную у Radeon HD 7790 от Sapphire. Та же пара DVI (Оба DL), HDMI, DP и вентиляционные вырезы.

Пока я не разобрал карту, давайте сравним её по длине с Radeon HD 7790 от Sapphire. Глядя на эту фотографию лично мне приходит только одна мысль – первое, что надо менять партнёрам NVIDIA у GTX 650 Ti BOOST – систему охлаждения, даже если PCB останется неизменной.

Демонтирую кулер GTX 650 Ti BOOST. Сначала откручиваю целую кучу тоненьких и длинных винтиков, снимаю пластиковый кожух СО. Под ним обнаружился ребристый брусок, закреплённый на четырёх подпружиненных винтах с обратной стороны печатной платы. Своим медным основанием брусок касается поверхности GPU, не трогая при этом микросхемы памяти, охлаждение которых, как и охлаждение системы питания, возложено на поток воздуха, создаваемый турбиной.

Система питания GPU и видеопамяти выполнена по схеме 4 (драйвер ON Semi. NCP5392G +1 (драйвер Anpec APL3516A). Плата несёт на борту 4 чипа памяти GDDR-5 производства Samsung K4G20325FD-FC03, номинальная эффективная частота которой составляет 6 ГГц

Вот и всё. Внешний осмотр закончен, пора действовать злодействовать!

Температуры. Разгон, тестирование в играх и синтетических пакетах. Выводы.

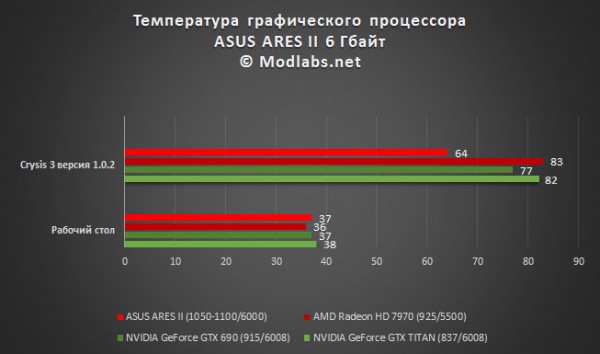

В этот раз я немного изменил конфигурацию тестового стенда. Наша станция переехала в новый корпус, а потому, сравнивать полученные сегодня результаты нагрева GPU с полученными ранее данными – не корректно, так что на графиках присутствуют только те ускорители, с которыми удалось провести повторные замеры температуры.

Обращаю ваше внимание, что сравнивать GTX 650 Ti BOOST и Radeon HD 7790 между собой не корректно, они не являются прямыми конкурентами друг другу, куда интереснее взглянуть на разницу температур с предполагаемыми “одноклассниками”. Конечно, нельзя сказать наверняка, как будет развиваться температурная битва в случае с другими парами ускорителей NVIDIA - AMD, однако в сегодняшнем поединке лидируют решения красных. Как ни крути, а карты NVIDIA в сравнении с аналогами AMD по-прежнему нагреваются больше, по крайней мере, в том ценовом сегменте, который рассматриваем мы. Что же касается уровня шума, то эталонный образец NVIDIA GeForce GTX 650 Ti BOOST лишь изредка напоминал о себе, в большинстве случаев не выделяясь на общем фоне системы, ну а Sapphire Radeon HD 7790 и вовсе показался мне тихоней, за что ему большое спасибо.

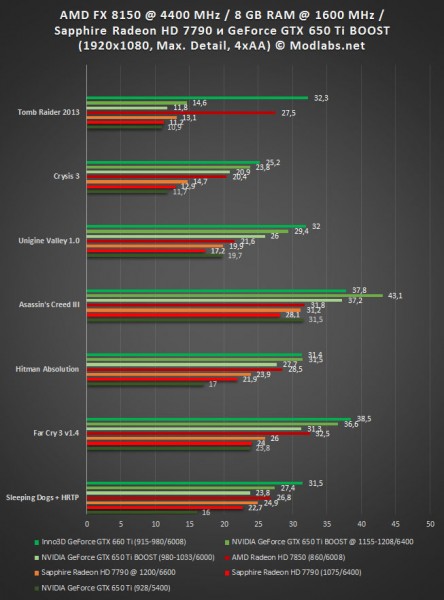

Теперь я займусь разгоном. В качестве основного инструмента я использовал утилиту MSI Afterburner 3.0 beta 9. Защита в драйверах AMD была выключена, проверка стабильности проходила в три этапа: двойной цикл 3DMark Fire Strike Extreme, двойной цикл 3DMark 11 Extreme и двойной цикл 3DMark Vantage Extreme. Если ускоритель проходил такие испытания, начиналось игровое тестирование. В результате я зафиксировал следующие частотные показатели:

- Sapphire Radeon HD 7790 @ 1200/6600

- NVIDIA GeForce GTX 650 Ti BOOST @ 1155-1208/6400

Пора переходить к тестированию производительности. Вот на чём были проведены тесты:

|

Конфигурация тестового стенда MODLABS |

|

|

Системная плата |

MSI 990FXA-GD80 – спасибо, MSI! |

|

Центральный процессор |

AMD FX-8150 @ 4400 МГц – спасибо, AMD! |

|

Оперативная память |

8 Гбайт AMD Entertainment Memory @ 1600 МГц – спасибо, AMD! |

|

Видеокарта |

Sapphire Radeon HD 7790 NVIDIA GeForce GTX 650 Ti BOOST |

|

Жёсткие диски |

1 Тбайт Seagate ES.2 |

|

Операционная система |

MS Windows 8 Professional x64 + upd |

|

Блок питания |

Seasonic SS-1250XM (80+ Gold)

|

| Версия драйверов видеокарты |

Для видеокарт NVIDIA 314.22 WHQL Для видеокарт AMD – Catalyst 13.1 |

А вот где и как были проведены тесты:

|

Список тестовых приложений |

|

Синтетические и полусинтетические тесты |

|

3DMark Vantage 1.1.0 (Performance, Extreme) |

|

3DMark 11 1.0.3.0 (Performance, Extreme) |

|

3DMark Professinal 1.0 (Cloud Gate, Fire Strike, Fire Strike Extreme) |

|

Unigine Valley 1.0 Extreme HD |

|

Unigine Heaven 4.0 Ultra + 4xMSAA |

|

Игры |

|

Во всех играх рабочее разрешение было установлено в 1920x1080, все детали, доступные в опциях игры или в настройках бенчмарка были выставлены на максимум. (В том числе и тесселляция) Полноэкранное сглаживание устанавливалось в режим MSAA 4x во всех играх, где эта опция была доступна, в противном случае выставлялся максимально близкий по качеству режим AA, эквивалентный 4xMSAA. Режим PhysX, если был доступен, выключался! |

|

Metro 2033 DX11 |

|

Batman Arkham City DX11 |

|

Lost Planet 2 DX11 |

|

Alien Versus Predator DX11 |

|

S.T.A.L.K.E.R CoP DX11 |

|

DIRT Showdown DX11 |

|

Sleeping Dogs DX11 |

|

Far Cry 3 DX11 |

|

Hitman. Absolution |

|

Asassin’s Creed III |

|

Crysis 3 версия 1.0.2 |

|

Tomb Raider (2013) |

К сожалению, из-за постоянной ротации семплов в тестовой лаборатории, а также неутомимого желания постоянно пополнять списки тестовых пакетов, мне не всегда удаётся провести дополнительное тестирование во всех играх и бенчмарках, поэтому заранее извиняюсь за отсутствие ряда результатов в тестовых пакетах 3DMARK.

Итак, вот что получилось. Ускоритель Radeon HD 7790 от Sapphire поборол старичка GTX 650 Ti в большинстве тестовых приложений. Конечно, в некоторых случаях разница была минимальной, а в некоторых случаях всё же чувствовался отрыв. Вы скажете, что Radeon HD 7790 от Sapphire разогнан производителем на заводе, на что я отвечу, что в случае с Radeon HD 7790 такое положение дел скорее всего будет сохраняться всегда, поскольку AMD, как было сказано на презентации, не планирует реализацию эталонных HD 7790, производство этого малыша целиком и полностью отдаётся в руки партнёров. Но, если хотите, вывод для этой парочки я могу перефразировать – Sapphire Radeon HD 7790 по всем характеристикам лучше эталонной версии GeForce GTX 650 Ti.

Что касается противостояния Radeon HD 7850 и новичка GeForce GTX 650 Ti BOOST, то здесь ситуация весьма неоднозначная. Я бы охарактеризовал результат поединка одной фразой – примерный паритет. Где-то NVIDIA вырывается вперёд, где-то AMD. Не буду высказывать своих предпочтений, смотрите результаты и думайте, какие из игр вам нравятся больше.

В результате весеннего противостояния мы с вами получили два свежих и весьма достойных графических ускорителя. Поклонники AMD смогут приобрести ускоритель стоимостью примерно в 4600-4800 рублей, любители NVIDIA смогут порадовать себя новинкой стоимостью чуть меньшей, чем 6000 рублей, причём, если судить по результатам, то в своих ценовых нишах оба адаптера полностью оправдывают свою стоимость.

Предлагаю обсудить материал в этой ветке форума. либо в нашей группе Facebook и ВКонтакте.

Боги против Титанов. Обзор и тестирование ускорителя ASUS ARES II на платформе AMD

Рубрика: ВидеокартыМетки: AMD | AMD FX | ARES II | ASUS | Radeon HD 7970 | нагрев | обзор ASUS ARES II | производительность | разгон | результаты | тестирование

Дата: 04/04/2013 02:00:00

<<При всей своей убеждённости современного человека в том, что боги Греции являются только продуктами фантазии и что они нигде и никогда не существовали, все эти боги встают перед нами…. >>

В.Али (RE XVI, 1376, s.v. Mythos)

Введение. Аппаратные особенности.

Есть ли смысл в создании самой мощной в мире графической карты, если основные продажи делаются в среднем ценовом сегменте? Ответ на этот вопрос может быть только один – да! Имидж, знаете ли. Для того, чтобы держаться на плаву, чтобы тебя уважали и о тебе говорили, ты должен делать нечто выдающееся. Вот компания ASUS постоянно стремится поддерживать свой статус выпуском эффектных и технически сложных решений, демонстрирующих в первую очередь высокий инженерный потенциал. Так, совсем недавно, в продажу поступил двухчиповый ускоритель ARES II, выпущенный ограниченным тиражом в 999 экземпляров. Во время анонса этого “графического божества” стало ясно, что и цена его будет “божественной”. На данный момент в московской рознице нам предлагают купить эту карту за 48 тысяч рублей. Очевидно, что очень немногие способны выделить на покупку графического ускорителя такие деньги, а значит, ARES II автоматически становится элитарным решением, владеть которым как минимум престижно, как максимум вы получите одну из самых быстрых и технологичных видеокарт в мире. Давайте посмотрим, на что способна очередная версия греческого бога войны - ASUS ARES II.

Внешний осмотр ускорителя начинается с его упаковки. В нашу тестовую лабораторию ускоритель был доставлен автомобилем, курьер принёс огромную коробку, габариты которой вполне соответствуют оным у системного блока или монитора. Посмотрите на размер, впечатляет?

Распотрошив картонную безликость, обнаружил прекрасно исполненную цветную коробку ASUS ARES II. Как говорится, под маской овечки скрывается волк, да ещё какой. На упаковке нет громких и кричащих надписей, описание всех преимуществ помещается на боковой части коробки, зато каких преимуществ! И если гибридной системой охлаждения и объёмом локальной видеопамяти в 6 Гбайт нас не удивишь, то заявление о том, что перед нами самая быстрая видеокарта – вполне! Учитывая размеры коробки, слова о том, что ARES II быстрее всех, вызывают доверие.

Дальше – больше. Открываем катонный бокс, а в нём, в пенопластовых тисках и пузырчатой обёртке чемодан из металла и пластика! Вот это упаковка! Зачастую потратив приличную сумму на приобретение какой-либо вещи, ждёшь внимания со стороны её производителя и не получаешь оного. А ведь хочется прийти домой, открыть коробку и увидеть, что каждая мелочь вложена в комплект не просто так. В случае с ARES II, открывая коробку, сразу понимаешь, что производитель сделал всё, чтобы покупатель столь дорогой вещи остался доволен приобретением.

Лёгкий трепет возникает при открытии чемодана. Неспроста! Внутри, в контейнере, изготовленном из мягкого полимера, находится сам графический ускоритель ASUS ARES II, а также все необходимые для его работы аксессуары. Всё это очень аккуратно разложено внутри по соответствующим ячейкам. Схожим образом в кино преподносят какое-нибудь элитное оружие.

Первый ярус занят его величеством ARES II, блоками его системы охлаждения, а также металлической дощечкой-сертификатом, подтверждающей подлинность данного продукта. Мне достался 387 экземпляр из 999 выпущенных.

Чуть ниже расположились дополнительные аксессуары Ареса. Все они также аккуратно разложены и упакованы. Полный их список таков:

Инструкция по эксплуатации

- Фирменный компакт-диск с драйверами и утилитами

- Три переходника питания

- Мостик CrossFireX

- Переходник с DVI на HDMI

- Комплект креплений для вентилятора системы охлаждения

- 120 мм вентилятор для радиатора СО

- Фирменная наклейка ASUS на корпус ПК

Ускоритель ASUS ARES II изготовлен очень качественно. Печатная плата Ареса закована в броню со всех сторон, никаких прогибов или болтающихся элементов замечено не было. Все разъёмы с открытыми контактными площадками закрыты специальными пластиковыми крышками для предотвращения повреждения или загрязнения контактов.

На панели выводов расположилась целая батарея разъёмов - пара DL-DVI, а также 4 полноразмерных выхода типа DP. Чуть ниже выгравирована правильная схема активации дисплеев. Особенность подключения состоит в том, что один из разъёмов DL-DVI переключается в режим SL при совместном использовании с соседним DP. Активация же режима DL-DVI для этого порта отключает один из портов DP, оставляя активными лишь оставшиеся три порта, такое переключение возможно при помощи специального переключателя между BIOS видеокарты с разными настройками.

В верхней части кожуха системы охлаждения находятся два специальных отверстия, через которые выходят трубки СВО, подключённые к радиатору. Через эти же отверстия также выводятся контакты, используемые для подключения вентиляторов, смонтированных на радиаторе СВО, что достаточно удобно, не нужно искать свободные разъёмы на материнской плате, реобасе или использовать новые “хвосты” БП. Радиатор, кстати, весьма качественный. Он изготовлен с расчётом на монтаж двух 120 мм вентиляторов, оба в комплекте. При монтаже второго вентилятора используйте прилагаемые в комплекте винты. Будьте внимательны, обращайте внимание на насечки, указывающие направление воздушного потока. В случае неправильного монтажа вертушки будут бороться не с нагревом, а друг с другом, что не лучшим образом скажется на эффективности отвода тепла. Глядя на радиатор СВО ASUS ARES II, мне кажется, что для их охлаждения односекционного радиатора, пусть и достаточно толстого, маловато. Разумнее, на мой взгляд, использовать двухсекционный радиатор. Думаю, что на удобства монтажа в большинстве случаев это почти никак не повлияет, а вот на эффективности охлаждения и уровне шума скажется положительно. Другое дело - Quad CrossFireX связка, которую можно собрать из двух ASUS ARES II. Если в системе два односекционных радиатора, их легко монтировать, а вот пара двухсекционных существенно усложняет задачу.

Обратите внимание, помимо используемой для охлаждения СВО, в центре платы также находится один вентилятор, освежающий атмосферу под кожухом радиатора, поскольку помимо GPU, охлаждением которой занимается СВО, есть ещё элементы питания и чипы памяти, которые тоже выделяют тепло.

Пришла пора рассмотреть внутреннее устройство ASUS ARES II. Для этого придётся, в первую очередь, снять тяжёлую “лицевую” защиту. Её демонтаж проходит при помощи ключа шестигранника.

Под крышкой скрываются два водоблока со встроенными в них помпами, а также вентилятор, охлаждающий внутреннее пространство под кожухом ARES II. Обращу ваше внимание на то, что оба водоблока и радиатор СВО заправлены на заводе и закольцованы в единый контур.

Продолжаем демонтаж системы охлаждения. Удивительно, но все элементы СО откручиваются без каких-либо проблем при помощи обычной крестовой отвёртки и лишь один винтик, который держит провод питания встроенных в водоблоки помп, требует наличие часовой отвёртки. Учитывая сложность разводки и близость всех элементов между собой, оставлять элементы платы без пассивного охлаждения было бы не разумно. Именно поэтому производитель использовал два радиатора – с лицевой и обратной стороны платы. Эти радиаторы контактируют с элементами системы питания, чипом коммутатором и микросхемами памяти через специальные термопрокладки.

Единственная проблема при разборке, проявилась во время отключения вентиляторов СО от платы. Вместе с самим коннектором снимались и пластиковые кроватки, но благодаря качественно нанесённой разметке на плате, правильно установить разъёмы на место не составило большого труда.

Основание водоблоков выполнено из меди и отполировано до зеркального блеска. Устанавливаются водоблоки также достаточно просто - легко вставляются в прорези охлаждающих пластин и закручиваются винтами с обратной стороны платы.

Как я уже говорил, разводка PCB невероятно сложна, все элементы располагаются очень плотно, так что богатый внешний вид ASUS ARES II сохраняется даже в “раздетом состоянии”. Для питание GPU выделено 8 фаз, по одной фазе на каждый набор системы памяти. Контроллер питания GPU – CHiL CHL8228G, контроллер питания памяти APW7165A. Судя по данным на официальном сайте ASUS, при производстве ASUS ARES II используются высококачественные элементы питания SAP (Super Alloy Power).

Память произведена компанией Hynix и несёт маркировку H5GQ2H24AFR-R0C. Номинальная эффективная частота для этих чипов памяти составляет 6 ГГц. Чип-коммутатор шины PCI-Express 3.0 - PLX PEX8747.

Требования к питанию у ASUS ARES II весьма суровые, поэтому на плате разведены и распаяны три 8-ми контактных разъёма питания PCI-Express. Когда кабели питания не подключены, рядом с коннекторами горят красные светодиоды, стоит только подключить кабели, как цвет светодиодов сменяется на позитивный зелёный.

Ещё об одной особенности ARES II, которая, впрочем, не является привилегией только этого ускорителя. На торце системы охлаждения Ареса располагается логотип Republic of Gamers и, собственно, название самого ускорителя. В темноте этот логотип светится.

Что бы я хотел сказать после осмотра Ареса: с точки зрения качества исполнения сложно найти какие-либо недочёты, все компоненты платы отлично состыкованы и закреплены, грамотно организовано охлаждение, внешний вид и вовсе заставляет молча восхищаться ускорителем. Единственное, что бы я сделал немного иначе, так это выбрал другой радиатор для СВО, побольше.

Теперь осталось проверить способности ARES II на практике, а заодно выяснить сможет ли Титан одолеть бога войны.

Конфигурация тестового стенда, настройки, результаты тестирования и выводы.

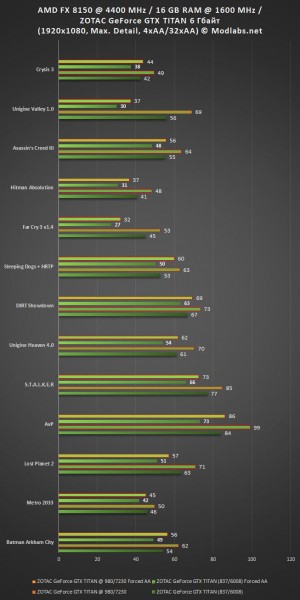

Тестовый стенд Modlabs, на котором проводилась проверка акустических и температурных характеристик, а также тесты производительности GeForce GTX TITAN от ZOTAC, был собран в составе корпуса Cooler Master Cosmos 1000S, все посадочные места которого заняты 120 мм вентиляторами, вращающимися со скоростью 1200 об./мин. Боковая стенка корпуса во время тестирования открыта. Конфигурация тестового стенда такова:

|

Конфигурация тестового стенда MODLABS |

|

|

Системная плата |

MSI 990FXA-GD80 – спасибо, MSI! |

|

Центральный процессор |

AMD FX-8150 @ 4400 МГц – спасибо, AMD! |

|

Оперативная память |

16 Гбайт AMD Entertainment Memory @ 1600 МГц – спасибо, AMD! |

|

Видеокарта |

ZOTAC GeForce GTX TITAN 6 Гбайт (837/6008) |

|

Жёсткие диски |

4x1 Тбайт Seagate ES.2 @ RAID0 |

|

Операционная система |

MS Windows 8 Professional x64 + upd |

|

Версия драйверов видеокарты |

314.09 WHQL |

|

Список тестовых приложений |

|

Синтетические и полусинтетические тесты |

|

3DMark Vantage 1.1.0 (Performance, Extreme) |

|

3DMark 11 1.0.3.0 (Performance, Extreme) |

|

Unigine Valley 1.0 |

|

Unigine Heaven 4.0 (Все детали и тесселляция установлены на максимум, 4xAA) |

|

Игры |

|

Во всех играх рабочее разрешение было установлено в 1920x1080, все детали, доступные в опциях игры или в настройках бенчмарка были выставлены на максимум, в том числе и тесселляция, полноэкранное сглаживание устанавливалось в режим 4x во всех играх. Режим PhysX, если был доступен, включался в режиме максимального качества. В драйверах PhysX не выключался нигде, кроме 3DMark Vantage. Также был проведён цикл игровых тестов с форсированными настройками драйверов или эквивалентными им настройками в опциях игр, если такие были доступны. Более подробно читайте об этом чуть выше. Десятые доли FPS отсекались, в силу неактуальности. |

|

Metro 2033 DX11 |

|

Batman Arkham City DX11 |

|

Lost Planet 2 DX11 |

|

Alien Versus Predator DX11 |

|

S.T.A.L.K.E.R CoP DX11 |

|

DIRT Showdown DX11 |

|

Sleeping Dogs DX11 |

|

Far Cry 3 DX11 |

|

Hitman. Absolution |

|

Asassin’s Creed III |

|

Crysis 3 версия 1.0.2 |

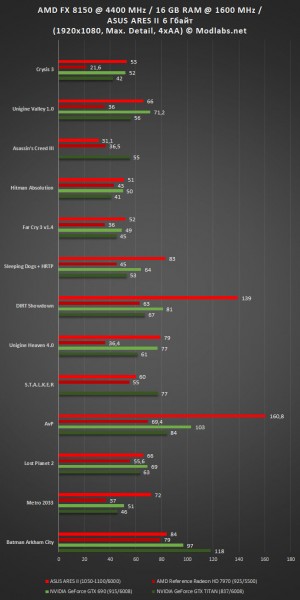

В целом, производительность графического ускорителя ASUS ARES II вызывает трепет. Карта действительно очень быстрая и при этом достаточно холодная. Этого результата удалось добиться благодаря двум факторам: с одной стороны сила пары Tahiti XT и мощносй системы памяти, с другой - грамотная разводка платы и мощная система охлаждения. Всё бы ничего, но ложку дёгтя в эту бочку мёда добавили драйверы. Ни последняя бета, ни самая свежая финальные версии драйверов не демонстрируют стопроцентную стабильность работы и высокую эффективность работы CrossFireX, в некоторых играх наблюдается снижение производительности относительно обычной Radeon HD 7970 (!). Кроме того, раз уж я коснулся темы драйверов, у меня есть ещё одно замечание к программистам AMD: если все компоненты платформы изготовлены AMD, в AMD Vision Engine Control Center наблюдается целая OverDrive тусовка - здесь и Graphics OverDrive и CPU OverDrive и AMD OverDrive... Разобраться во всём этом наборе сходу не представляется возможным. Хотелось бы получить более прозрачную систему контроля за параметрами системы. И, наконец, вопрос, касающийся CrossFireX профилей: было бы неплохо получать обновления оных вместе со свежими драйверами, а то и чаще.

Теперь что касается разгона. Карта стабильно работала с красивой частотной формулой 1200/6700, однако из-за ограничений со стороны CPU, в играх прирост практически отсутствовал, а потому тестирование на стенде AMD разогнанной карты, по крайней мере для FHD разрешения, особого смысла не имеет.

Итоги.

Битва богов и титанов в данном случае закончилась победой олимпийцев, на стороне которых оказался невероятно стойкий и производительный боец - ARES II. Если вы решитесь на покупку Ареса, будьте на 100% уверены в том, что этот графический ускоритель подарит вам незабываемые впечатления от игр. Карта ARES II действительно очень быстра, достаточно холодна для своего класса и при этом уровень шума от вентиляторов штатной СО не заставляет сходить с ума. Единственное пожелание к владельцам данной карты - обновляйте драйверы почаще.

P.S. Каждое новое тестирование графических ускорителей экстра класса заставляет меня задуматься о целесообразности их покупки, если разрешение монитора не выходит за рамки обычного 1920x1080. Думаю, что под стать Titan'ам и ARES'ам нужно покупать либо один монитор с разрешением 2560x1600, а то и вовсе "запрягать тройку" из таких мониторов,

Ускоритель ASUS ARES II удостоен редакцией Modlabs сразу двух наград:

Обсуждение материала ведётся здесь.

Титан расправил крылья! Обзор и тестирование ZOTAC GeForce GTX TITAN на платформе AMD.

Рубрика: ВидеокартыМетки: AMD | ARES II | ASUS | DirectX 11 | GeForce GTX TITAN | NVIDIA | ZOTAC | архитектура | обзор | разгон | тестирование

Дата: 12/03/2013 21:34:36

Вступление. Архитектура GK110, новые возможности GeForce GTX TITAN.

Ещё несколько месяцев назад на страницах зарубежных новостных ресурсов стали появляться скудные данные о некоем мифическом 3D ускорителе от компании NVIDIA. Судя по первым слухам, которые, впоследствии подтвердились, новая видеокарта должна была получить гордое имя “TITAN”, а её сердцем должен был стать супермощный GPU с архитектурой Kepler. Скептики не верили в существование Титана, поклонники же, отнюдь, всем сердцем ждали новинку и пророчили флагманской графике AMD поражение в борьбе с зелёным монстром. Так бы и продолжались словесные перепалки, если бы, наконец, не произошёл долгожданный анонс, после которого все смогли оценить способности новоиспечённого одночипового флагмана. Ну а я, в свою очередь, после того, как эмоциональный накал от выхода GeForce GTX TITAN немного спал, хочу спокойно и без спешки посмотреть на производительность ускорителя GeForce GTX TITAN в самых современных играх вроде Tomb Raider и Crysis 3. Сделаю я это не так как большинство журналистов, поскольку в отличие от многих в нашей тестовой лаборатории используется платформа AMD.

Прежде всего, как мне кажется, нужно разобраться с архитектурой графического процессора GeForce GTX TITAN. Начнём.

Знаю наверняка, от чего не умрут маркетологи NVIDIA. От скромности :) Новый ускоритель GeForce GTX TITAN зовётся основой для игрового суперкомпьютера. Звучит, конечно, красиво, однако так можно назвать, пожалуй, любую игровую станцию на базе одной или нескольких флагманских видеокарт, по крайней мере, на стадии анонса или сразу после него. Впрочем, не буду придираться, продолжу.

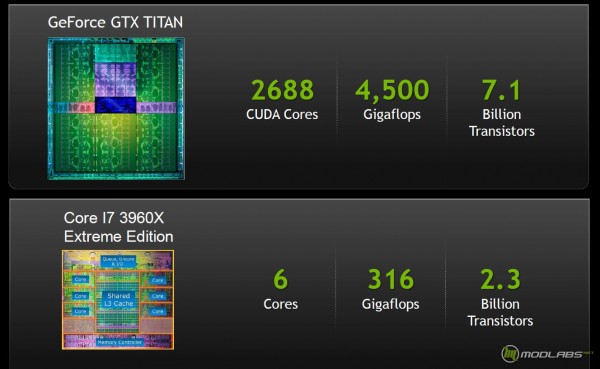

Осознание способностей графического процессора GeForce GTX TITAN, лучше всего приходить после выставления точки отсчёта. В данном случае ей стал один из экстремальных процессоров Intel – Core i7 3960X Extreme Edition. По сравнению с этим чипом, GPU TITAN, действительно, является суперкомпьютером, жаль только, что вся эта вычислительная мощь актуальна для игроков лишь при наличии маленького кусочка кремния от Intel или AMD....

Чтобы понять, откуда растут ноги, и благодаря чему удалось достичь столь впечатляющих вычислительных показателей, нужно немного углубиться в историю и покопаться в архитектуре GPU ускорителя GeForce GTX TITAN. Дело в том, что после анонса графических ускорителей поколения Kepler, стало ясно, что GeForce GTX 680 не состоялся как флагман в полном смысле этого слова. Этот ускоритель использовал GPU GK104, который, по своей топологии оказался больше похож на Middle-High продукт, нежели на флагманское решение. Чтобы убедится в этом, посмотрите на устройство чипов GF110 и GF114 на базе Fermi, поймёте о чём я. Судя по всему, технологические проблемы не позволили NVIDIA в разумные сроки наладить массовый выпуск полноценных GK110 и, чтобы даром время не терять, был найден компромисс. В общем-то, NVIDIA этого факта и не скрывала, GeForce GTX 680 был временным игроком, который должен был получить более мощного преемника как только удастся решить проблемы с 28-нм техпроцессом. Впрочем, при кажущейся простоте, GeForce GTX 680 обладал отличной производительностью и довольно неплохими характеристиками энергопотребления и тепловыделения. Теперь, с выпуском графического ускорителя GeForce GTX TITAN инженеры компании подвели некоторую технологическую черту, за которую одночиповые решения NVIDIA вряд ли выйдут в рамках архитектуры Kepler, поскольку настольная версия GK110 получила практически все заложенные в неё возможности.

Графический процессор GK110 содержит блок управления потоками, именуемый GigaThread Enginе, кеш память для инструкций и данных, контроллеры памяти, блоки растровых операций, а также Graphics Processing Clusters (GPC), который выполняет вычислительные операции и операции с текстурами. В составе GK110 находятся пять блоков GPC. Внутри каждого GPC, в свою очередь, находится по одному движку растеризации, а также по три так называемых SMX (SM – в терминологии NVIDIA для GPU Tesla и Fermi) - потоковых мультипроцессора. В отличие от серверного Tesla K20/K20X, в составе которых трудится полноценная версия GK110 с 15-ю активными блоками SMX, настольный графический чип GK110 получил лишь 14 активных потоковых мультипроцессора. Количество текстурных блоков равно 224, а блоков растеризации – 48.

В составе SMX трудятся 224 текстурных блока и 48 ROP (блоков растеризации), особого рассмотрения заслуживают блоки операций с двойной точностью. Общее количество блоков FP64 (те самые блоки операций с двойной точностью) составляет 896 штук, по 64 на каждый SMX, – это положительное отличие от GK104. Не очень хорошо то, что по умолчанию, ядра, предназначенные для работы с FP64, работают на 1/8 от частоты других блоков, размещённых в SMX. Правда стоит отметить, что в драйверах есть возможность поднять тактовую частоту FP64 блоков, переключив видеокарту в режим “CUDA двойная точность”, однако общая тактовая частота GPU снизится. Вот что получилось при запуске 3D приложения после включения вышеозначенной опции (значения Temp Target было сдвинуто до 90 градусов Цельсия):

Отключаем режим двойной точности, получаем:

Так вот, поскольку суммарное количество ядер CUDA в GK110 равно 2688 (по 192 штуки на один блок SMX), а количество FP64 блоков – 896, получаем, что соотношение FP64/FP32 блоков = 1/3. Если вспомнить, что FP64 блоки работают на 1/8 частоты GPU, получим, что эффективность выполнения операций с двойной точностью составляет 1/24 от FP32! Да, да, близкая ситуация в FP64 операциях была и у GeForce GTX 680, из за столь же низкой эффективности таких вычислений он “сливал” старине GTX 580. Вот только в данном случае низкая эффективность при работе с FP64 компенсируется за счёт колоссального увеличения количества самих вычислительных блоков. У AMD, кстати, при переходе к FP64 провал заметно меньше, скорость падает примерно вдвое. Это, конечно, на словах звучит страшно, на практике же, применительно к играм, всё не так плохо, скорее даже очень хорошо, поскольку архитектура Fermi, а теперь и Kepler имеет не так много слабых мест и решения на её основе более чем конкурентоспособны.

Контроллер памяти у GK110 заметно подтянут относительно оного у GK104, теперь он 384 битный, против 256 битного, а суммарный объём локальной видеопамяти GeForce GTX TITAN составляет 6144 Мбайт = 6 Гбайт! Здесь полный порядок.

В итоге мы получаем, что настольная версия видеокарт, базирующихся на GPU GK110, обладает следующими характеристиками.

Ещё пару лет назад, снимок экрана с окном программы GPU-Z, отображающей характеристики GeForce TITAN, сочли бы как минимум поддельными, а как максимум, назвали бы автора этих снимков сумасшедшим. Нынче же ситуация иная, перед нами настоящий Титан, по крайней мере по формальным характеристикам. Согласитесь, тактовые частоты GPU 837/876 МГц, частота видеопамяти 6008 МГц, шина памяти 384 бит (ПСП памяти 288 Гбайт/с), 48 блоков растеризации и 224 текстурных блока, 2688 ядер CUDA и всё это при использовании 7,1 млрд. транзисторов! Даже сейчас это выглядит круто, при этом TDP платы GeForce GTX TITAN не пугает современного пользователя – всего 250 Вт.

Если по части архитектуры GPU и подсистемы памяти мы разобрались, то оверклокерские характеристики ещё требуют описания. Уж поверьте, есть на что обратить внимание. Эти данные, определённо, нужно будет учитывать при подходе к разгону.

Динамический разгон. Технология NVIDIA GPU Boost ver. 2.0

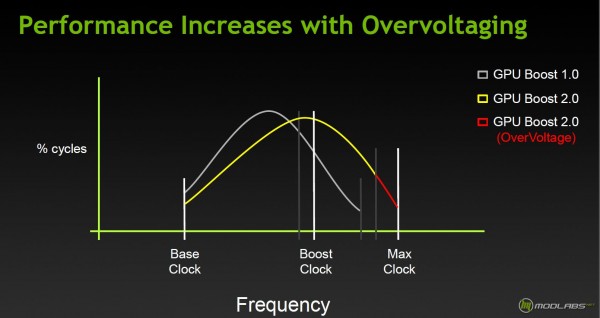

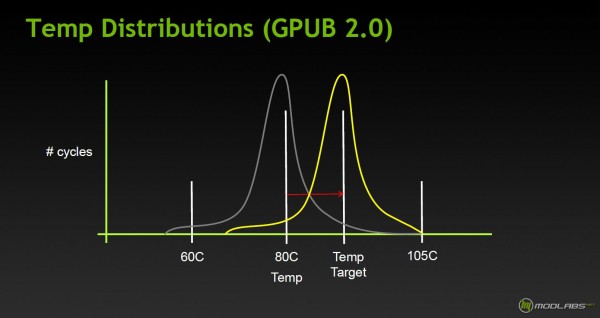

Итак, первая версия технологии форсирования частоты GPU от NVIDIA в своей работе учитывала только один параметр – предел мощности/напряжение GPU, который изменялся в определённых рамках. Сейчас же появился ещё один фактор – предельная температура, при которой GPU в состоянии функционировать без сбоев.

По умолчанию значение предельной температуры выставлено на уровень 80 градусов Цельсия, однако пользователь вручную может изменить этот уровень до 94 градусов. Такое смещение позволит работать графическому процессору под нагрузкой при более высоких частотах. Судя по слайдам с презентации, именно рабочая температура GPU будет решающим фактором в достижении максимальной частоты при работе GPU Boost 2.0.

На практике при разгоне видеокарты мы будем выставлять не только значение Power Target, но и Temperature Target. Кстати, отмечу, что в технической документации от NVIDIA написано о возможности регулировки напряжения как об опции, которая может быть выключена производителем посредствам VBIOS. Думаю, что вряд ли кто-то будет намеренно глушить эту возможность.

Одной из интересных возможностей ускорителей NVIDIA является технология адаптивной вертикальной синхронизации, суть которой заключается в нивелирование эффекта “разрыва кадра” и “подёргиваний“ картинки при резком изменении частоты смены кадров. Новизна Adaptive V-sync в случае с GeForce GTX TITAN заключается в том, что отныне ограничение частоты смены кадров при адаптивной вертикальной синхронизации можно увеличить до 120 Гц включительно.

Напоследок, хочу вспомнить о технологии NVIDIA SLI. Не секрет, что максимальное количество одновременно задействованных GPU в системе с видеокартами NVIDIA может достигать четырёх. Пара GeForce GTX 690 – отличный пример работы 4-Way SLI. Использование такого тандема, как мне кажется, оправдано довольно редко, поскольку помимо ограничений в вычислительной мощи центрального процессора, остро стоит проблема синхронизации четырёх чипов для работы над картинкой. Коэффициент полезного действия 4-Way SLI систем существенно ниже, чем у, скажем, 2-Way или 3-Way SLI. Зная об этом, NVIDIA с выходом GeForce TITAN активно продвигает тему 3-Way SLI, как самую оптимальную с точки зрения эффективности и самую высокопроизводительную. На мой взгляд, такое позиционирование оправдывает себя, особенно для видеосистемы класса TITAN. Вот только крайне рекомендую для “Титановых” SLI связок обзавестись мощнейшим процессором, да ещё и разогнать его.

На этом я заканчиваю теоретическую часть материала, пришла пора знакомиться с Титаном лично.

Ускоритель ZOTAC GeForce GTX TITAN. Внешний вид и особенности аппаратного оснащения.

Всё, как обычно, начинается с упаковки. Она, пожалуй, единственное, что отличает ZOTAC GeForce GTX TITAN от большинства выпущенных на данный момент “Титанов” других производителей. Перед нами красочный чехол из тонкого картона, который опоясывает достаточно увесистую коробку, в которой находится набор аксессуаров и сам ускоритель. Помимо основных технических данных, нам сходу сообщают о том, что на этот продукт действует расширенная гарантия от ZOTAC, а также о том, что внутри нас ждёт подарок – три игры из серии Assasin’s Creed. Те, кто любит эти игры, оценит, остальные же отнесутся спокойно, поскольку игры из подарочного комплекта уже не так свежи. как того хотелось бы.

Открываем картонный чемодан. Сверху, под крышкой из прозрачного пластика находится видеокарта ZOTAC GeForce GTX TITAN, она лежит в “кроватке” из пористого синтетического материала. Именно эта кроватка защищает Титана от повреждений при транспортировке.

Вытаскиваю видеокарту, залезаю глубже, нахожу аксессуары, заботливо уложенные на заводе в отдельный картонный бокс. Помимо бумажного сопровождения и диска с драйверами я обнаружил обещанные игры из серии Asassin’s Creed (серийники к которым я, с вашего позволения, замазал), пару переходников питания, переходник с DVI на VGA и фирменную наклейку ZOTAC. Уж не знаю, нужно ли что-то ещё покупателю такой вот видеокарты, а лично мне, как обозревателю, этого набора вполне хватает.

Бог с ними, с бумажками. Вот он, герой обзора. Честно сказать, вопреки своей привычке, я очень долго рассматривал GeForce GTX TITAN, крутил плату в руках и никак не мог нарадоваться. На мой вкус, этот ускоритель можно назвать одним из самых правильных с эстетической точки зрения. Пару или даже тройку Титанов нужно ставить в корпус с прозрачной боковой стенкой, чтобы наблюдать всё это великолепие как можно чаще. Крышка системы охлаждения выполнена из алюминия, ближе к панели выводов выдавлена надпись TITAN, ближе к корме присутствует логотип NVIDIA.

Через прозрачное стекло, изготовленное из полимера, видны рёбра радиатора системы охлаждения.

Кстати, при включении видеокарты надпись GeForce GTX светится зелёным цветом, оценить это свечение можно на фото, приведённом чуть ниже.

Панель выводов оснащается четырьмя выходами, два из которых – DVI-I и DVI-D, ещё пара – это полноразмерные HDMI и DisplayPort. Лично для меня такой набор выходов является идеальным, поскольку обычно я использую сразу два DVI разъёма для подключения монитора и плазменной панели. Как и положено флагману, GeForce GTX TITAN от ZOTAC поддерживает разрешение 4K.

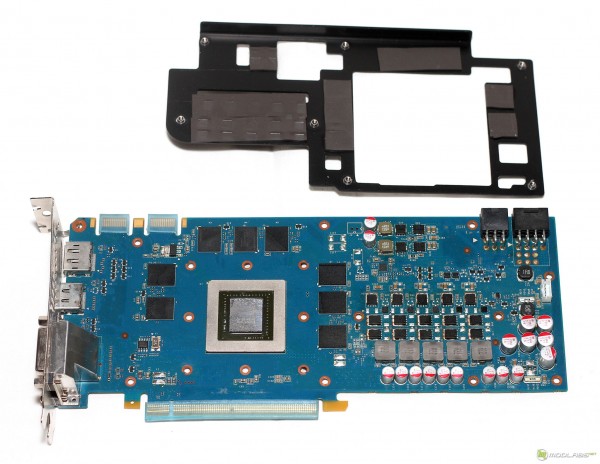

Демонтирую систему охлаждения. Процесс проходит легко и непринуждённо. В отличие от первых плат на базе GPU Fermi, для демонтажа системы охлаждения которых предполагалось использование небольшого гранёного ключика, ускоритель GeForce GTX TITAN разбирается при помощи обычной отвёртки. Слава Богу, производитель не стал мудрить с креплением, винтов много, но процесс демонтажа прост как устройство молотка. Я сознательно не стал разбирать систему охлаждения до винтика, поскольку ничего принципиально нового в её устройстве нет. Кулер представляет собой конструкцию из испарительной камеры, радиатора и турбины, прокачивающей воздух сквозь рёбра радиатора, выводя потоки горячего воздуха за пределы корпуса. Подошва испарительной камеры через тонкий слой термопасты контактирует с кристаллом GK110, в то время как сильно греющиеся элементы системы питания, а также чипы памяти отдают тепло на металлическое основание кулера через специальные термопрокладки.

Полная маркировка GPU ускоритель ZOTAC GeForce GTX TITAN такова:

A TAIWAN 1251A1

NFF532.M3W

GK110-400-A1

Чип GK110 имеет ревизию A1 и изготовлен на 51 неделе 2012 года. Для оценки размеров кристалла GF110, взгляните на фото. Десятирублёвая монета помещается целиком, да ещё и остаётся достаточно много места. Как ни крути, а чип получился гигантский, его площадь составляет 561 кв. мм. Металлическая рамка вокруг GPU защищает кристалл от сколов, полезно при установке нестандартной системы охлаждения.

Без системы охлаждения плата GeForce GTX TITAN выглядит не так эффектно, тем не менее, вид флагмана плата сохраняет даже “голышом”. Двадцать четыре микросхемы памяти Samsung K4G20325FD-FC03 размещены по обе стороны печатной платы, микросхемы, расположенные на обратной стороне PCB никак не охлаждаются. Номинальная эффективная тактовая частота для этих чипов памяти составляет 6 ГГц.

За питание графического процессора отвечают 6 фаз, управляемых микросхемой ON Semiconductor NCP4206. Питание памяти двухфазное, для питания PLL выделана одна фаза. В системе питания использованы высококачественные компоненты Dr.Mos.

В общем-то, с описанием теории и аппаратного устройства GeForce GTX TITAN, пожалуй, всё, самое время переходить к практическим испытаниям.

Нагрев, уровень шума. Пара слов о необходимости разгона. Тесты.

Тестовый стенд Modlabs, на котором проводилась проверка акустических и температурных характеристик, а также тесты производительности GeForce GTX TITAN от ZOTAC, был собран в составе корпуса Cooler Master Cosmos 1000S, все посадочные места которого заняты 120 мм вентиляторами, вращающимися со скоростью 1200 об./мин. Боковая стенка корпуса во время тестирования открыта. Конфигурация тестового стенда такова:

|

Конфигурация тестового стенда MODLABS |

|

|

Системная плата |

MSI 990FXA-GD80 – спасибо, MSI! |

|

Центральный процессор |

AMD FX-8150 @ 4400 МГц – спасибо, AMD! |

|

Оперативная память |

16 Гбайт AMD Entertainment Memory @ 1600 МГц – спасибо, AMD! |

|

Видеокарта |

ZOTAC GeForce GTX TITAN 6 Гбайт (837/6008) |

|

Жёсткие диски |

4x1 Тбайт Seagate ES.2 @ RAID0 |

|

Операционная система |

MS Windows 8 Professional x64 + upd |

|

Версия драйверов видеокарты |

314.09 WHQL |

Как вы уже поняли, в качестве основы для тестового стенда использовалась система на базе AMD FX 8150, разогнанного до 4400 МГц. В таком виде эта машина весьма производительная и способна осилить любую из современных игр, однако в сравнении с флагманскими системами Intel, наш боец FX всё-таки проигрывает и местами достаточно заметно. Именно поэтому, для того, чтобы минимизировать влияние процессора на потенциал GeForce GTX TITAN, нужно нагрузить графическую систему по максимуму. Так я и сделал. Помимо стандартных настроек игр на максимальное качество при разрешении 1920x1080 с 4-х кратным полноэкранным сглаживанием MSAA и 16-ти кратной анизотропной фильтрации, я провёл дополнительное тестирование, при котором настройки полноэкранного сглаживания форсировались вручную через драйвер или выставлялись в опциях игр, разумеется, при наличии соответствующих опций, эквивалентных настройкам драйверов. Форсированные настройки драйверов 314.09 выглядят так:

В деле влияния CPU на результаты, не стоит также забывать, что не каждая современная игра способна “получать удовольствие” от наличия в системе 8-ми ядерного CPU. Об этом, кстати, мы уже писали и подкрепили наши слова результатами тестов. С этим фактом, как мне кажется, связан проигрыш процессоров AMD FX в играх, которые не могут использовать все активные ядра флагманских процессоров FX, в то время как камни Intel за счёт большей мощи отдельных ядер вырывались вперёд. К сожалению, мы не можем сравнить полученные нами результаты с оными на платформе Intel ввиду временного отсутствия соответствующего оборудования, так что пока оставим эту тему, до появления актуальной системы на базе чипов Intel.

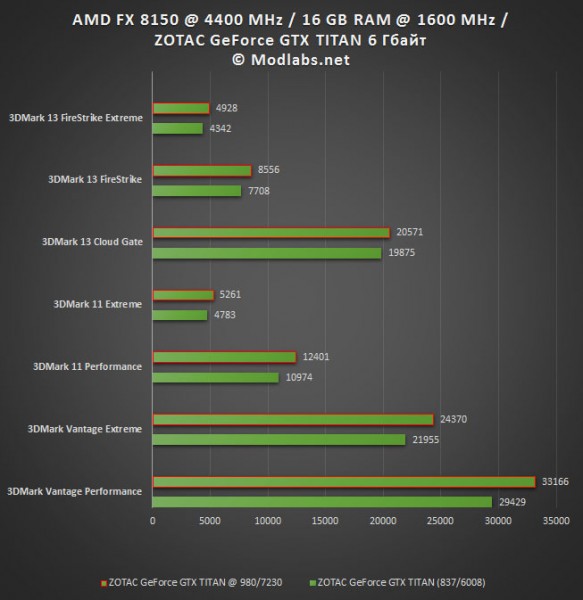

Что же касается разгона, то для выяснения частотного потенциала моего образца ZOTAC GeForce GTX TITAN, была использована утилита EVGA Precision X. Обороты системы охлаждения были установлены на максимум, значение Power Target было увеличено до 106%, а Temp Target до 90 градусов Цельсия. Базовую частоту GPU удалось поднять до стабильного уровня в 980 МГц, а частоту памяти до 7230 МГц. Максимальная турбо частота при активации технологии GPU Boost составила 1142 МГц, отмечу, правда, что такой потолок был достижим далеко не во всех играх, а там, где достижим, на такой частоте видеокарта работала не долго. Как правило, карта работала на 1078 МГц.

Для тестирования уровня шума и исследования процесса нагрева GPU я отказался от использования теста MSI Kombustor и FurMark, вместо этого тесты проводились в игре Crysis 3, при этом настройки качества картинки были выставлены на максимум, использовалось разрешение 1920x1080, также был задействован режим сглаживания MSAA 8x.

Без разгона графический процессор ускорителя ZOTAC GeForce GTX TITAN разогрелся не более 82 градусов Цельсия, при этом максимальная тактовая частота, которую удалось зафиксировать во время тестирования в играх, составила 1010 МГц. Что же касается уровня шума, то для столь быстрой видеокарты, я бы сказал, что ZOTAC GeForce GTX TITAN почти не шумит. В 2D карту не слышно, а в 3D, на фоне остальных компонентов из состава тестового стенда, этот ускоритель выделяется, но незначительно, долгой игре этот шум никак не мешает. Прямое сравнение температуры GPU GK110 до и после разгона вряд ли можно назвать справедливым, поскольку в момент разгона турбина ZOTAC GeForce GTX TITAN работает на 100% своей мощности.

Обращу ваше внимание на тот факт, что тестирование ускорителя GTX TITAN проводилось до фотосессии видеокарты, как следствие, использовалась термопаста, нанесённая производителем! После фотосессии, на очищенный кристалл GPU был нанесён слой Noctua NT-H1, на фото представлен не окончательный вариант (в реалии оставлен более тонкий слой):

|

Список тестовых приложений |

|

Синтетические и полусинтетические тесты |

|

3DMark Vantage 1.1.0 (Performance, Extreme) |

|

3DMark 11 1.0.3.0 (Performance, Extreme) |

|

Unigine Valley 1.0 |

|

Unigine Heaven 4.0 (Все детали и тесселляция установлены на максимум, 4xAA) |

|

Игры |

|

Во всех играх рабочее разрешение было установлено в 1920x1080, все детали, доступные в опциях игры или в настройках бенчмарка были выставлены на максимум, в том числе и тесселляция, полноэкранное сглаживание устанавливалось в режим 4x во всех играх. Режим PhysX, если был доступен, включался в режиме максимального качества. В драйверах PhysX не выключался нигде, кроме 3DMark Vantage. Также был проведён цикл игровых тестов с форсированными настройками драйверов или эквивалентными им настройками в опциях игр, если такие были доступны. Более подробно читайте об этом чуть выше. Десятые доли FPS отсекались, в силу неактуальности. |

|

Metro 2033 DX11 |

|

Batman Arkham City DX11 |

|

Lost Planet 2 DX11 |

|

Alien Versus Predator DX11 |

|

S.T.A.L.K.E.R CoP DX11 |

|

DIRT Showdown DX11 |

|

Sleeping Dogs DX11 |

|

Far Cry 3 DX11 |

|

Hitman. Absolution |

|

Asassin’s Creed III |

|

Crysis 3 версия 1.0.2 |

Изначально я хотел включить в список тестов Tomb Raider 2013, однако игра отказалась запускаться и пока придётся обойтись без неё.

Выводы.

Результаты тестов свидетельствуют о том, что NVIDIA проделала очень серьёзную работу по подготовке GeForce GTX TITAN. И действительно, на примере ZOTAC GeForce GTX TITAN видно, что карта удалась. Восхитительная производительность в тяжёлых режимах делает её незаменимым спутником для богатого игрока, который хочет выжать всё, что только можно из своей системы. Любители собирать компьютер “про запас” также не будут обделены. Если позволяют средства, можно собрать связку из трёх Титанов, благодаря чему, как мне кажется, в ближайшие полтора – два года можно забыть об апгрейде, разумеется, если не произойдёт неожиданного скачка в области требований к графической подсистеме со стороны актуальных на тот момент игр.

Помимо высокой производительности, к достоинствам ZOTAC GeForce GTX TITAN можно отнести низкий уровень шума стандартной системы охлаждения, что тоже не маловажно в домашнем игровом ПК. Тем не менее, несмотря на столь выдающиеся возможности, я бы не стал торопиться с выводами и записывать GeForce GTX TITAN в однозначные лидеры среди всех одиночных видеокарт, ведь красному лагерю тоже есть чем ответить, например “залпом” из двух GPU видеокарты ASUS ARES II, но об этом в другой раз. А пока битва Богов и Титанов только готовится, я, пожалуй, выдам продукту ZOTAC награду.

Графический ускоритель ZOTAC GeForce GTX TITAN удостоен награды "Выбор редактора" за март 2013 года.

Графический ускоритель ZOTAC GeForce GTX TITAN удостоен награды "Выбор редактора" за март 2013 года.

Предлагаю обсудить материал у нас в форуме.

P.S. Заранее отвечая на вопрос о целесообразности покупки трёх Титанов для объединения их в связку, скажу, что помимо обычных конфигураций, работающих с одним монитором, пусть даже и очень большим, есть ещё конфиги, например, с тремя мониторами, да ещё и с поддежкой 3D, а это значит, что столь мощные конфигурации оправданы уже сегодня!

Графика с характером. Обзор AMD Radeon HD 7850 от XFX и Gigabyte

Рубрика: ВидеокартыМетки: AMD | CrossFireX | Radeon HD 7850 | производительность | разгон | температуры | тестирование | уровень шума

Дата: 10/03/2013 03:03:33

Введение. XFX Radeon HD 7850 Core Edition 1024 Мбайт

У каждого человека, определённо, есть свой характер. Даже близнецы, при всём своём внешнем сходстве, имеют отличительные поведенческие качества. Вот так и с видеокартами, платы на базе одного и того же GPU могут заметно отличаться по своим оверклокерским возможностям, даже в рамках одной партии, у одного производителя, что уж говорить о двух адаптерах от разных изготовителей. Так вот, сейчас я расскажу вам о двух видеокартах на базе GPU AMD с кодовым именем Pitcairn. Первый ускоритель произведён компанией XFX, другой же выполнен на мощностях Gigabyte. Вначале мы рассмотрим эту парочку поодиночке, а после проверим, насколько эффективно они работают в CrossFireX связке. Пренебрегая алфавитными последовательностями, начну с ускорителя XFX.

Люблю я качественные упаковки, что и говорить. Приятно, когда купленный тобой продукт оформлен со старанием и заботой об эстетической составляющей. С этой точки зрения продукт XFX порадовал. Коробка башенного типа оформлена и впрямь весьма эффектно. Производитель заполнил описаниями все грани этого картонного параллелепипеда, так что потенциальный покупатель может ознакомиться с информацией об объёме локальной видеопамяти, типе используемой шины, количестве и типе видеовыходов, системе охлаждения и т.д. На мой вкус, описание достаточно неплохое, подробное.

Внутри коробки полный порядок. Сам ускоритель и прилагаемые аксессуары находятся в двухъярусной “кроватке”. Вверху аккуратно разложены аксессуары, чуть ниже расположился сам ускоритель. По большей части в комплекте с XFX Radeon HD 7850 Core Edition можно обнаружить лишь различные документации и рекламные брошюры, однако не все они бесполезны. Например, помимо инструкции, вполне может пригодиться информационная брошюра с информацией о различных переходниках для разных источников видеосигнала. Из приятных мелочей отмечу табличку на дверь с надписью “Do Not Disturb” (не беспокоить). Что же касается “железячных” дополнений, то кроме гибкого мостика CrossFireX ничего в комплекте не оказалось. Жаль.

Сам ускоритель выглядит так же эффектно, как и его упаковка. Матово чёрный текстолит платы прекрасно сочетается с прекрасной алюминиевой крышкой системы охлаждения. На мой взгляд, этот графический “кирпичик” производит впечатление качественного и надёжного продукта. Правда, не буду забегать вперёд и перед тем, как хвалить продукт, проведу исследование его возможностей.

Панель выводов XFX Radeon HD 7850 Core Edition богата на разъёмы. Пара DVI-D, пара Mini-DP, HDMI – всего пять разъёмов. Особо отмечу, что HDMI и DP порты поддерживают вывод изображения в формате 4Кю Пока данный формат не получил широкого распространения, но такие возможности явно не лишние.

Демонтирую крышку системы охлаждения. За отвод тепла от графического процессора, чипов памяти и системы питания отвечает один единственный радиатор с вентилятором в центре. Конструкция проста и надёжна как автомат Калашникова, однако её эффективность, откровенно говоря, под вопросом. Дело в том, что чипы памяти и элементы системы питания охлаждаются лишь потоками воздуха, создаваемыми тем самым единственным вентилятором. Помочь в этом вопросе призван алюминиевый кожух, конструкция которого как раз и разработана для улучшения движения воздушных потоков С ней элементам на плате, должно “дышаться” легче. Что касается самого радиатора и вентилятора, то он представляет собой медное основание, в которое впаяны две тепловые трубки, на них, в свою очередь, нанизаны алюминиевые рёбра. Диаметр тепловых трубок составляет 8 мм.

На плате установлены чипы памяти производства компании Elpida memory. Суммарный объём установленной памяти составляет 1 Гбайт, тип памяти – GDDR-5, маркировка W1032BBBG -50-F, паспортная эффективная частота составляет 5 ГГц (1,25 ГГц).

Система питания XFX Radeon HD 7850 Core Edition обладает следующими возможностями:

- ШИМ - uP1608PK . Доступно программное управление напряжением силами большинства актуальных программ для разгона видеокарт.

- Для питания GPU выделены 3 фазы

- Для питания PLL и памяти выделено по 1-ой фазе

От эталонной версии Radeon HD 7850 система питания XFX отличается отсутствием одной фазы питания для GPU.

В общем-то, на этом рассмотрение аппаратных особенностей XFX Radeon HD 7850 Core Edition я завершаю, результаты тестирования этой карты вы увидите чуть позже, а пока я перехожу к описанию второго героя данного материала – видеокарте Gigabyte Radeon HD 7850 (GV-R785OC-1GD).

Gigabyte Radeon HD 7850 (GV-R785OC-1GD)

Плата Gigabyte, в отличие от продукта XFX, оформлена проще, тем не менее, продукт выглядит весьма неплохо, в данном случае эта самая простота не вредит. Производитель сообщает о частоте GPU, рассказывает о ряде ключевых особенностей Radeon HD 7850 и, конечно, делает акцент на фирменной системе охлаждения WindForce 2X.

Комплект Radeon HD 7850 от Gigabyte весьма аскетичен. Инструкция, диск с драйверами, мостик CrossFire и переходник питания с пары Molex на PCI-Express. Судя по всему, век переходников с DVI на D-Sub закончился ввиду отмирания последнего. Даёшь полностью цифровые мониторы!

Печатная плата, на базе которой выполнен ускоритель GV-R785OC-1GD, выкрашена в фирменную бирюзу Gigabyte. Все разъёмы, в том числе и на панели выводов, закрыты специальными заглушками, предотвращающими засорение разъёмов. Не знаю насколько это актуально на первом этапе эксплуатации, но вообще, такая забота не лишняя, учитывая, что почти у всех “системник” забивается пылью достаточно быстро.

Панель выводов у платы Gigabyte мне понравилась меньше, чем в случае с решением XFX. Выхлопная решётка “съела” один из DVI-D разъёмов, что лично для меня очень неудобно, поскольку я постоянно подключаю к плате два DVI разъёма и городить огород с переходниками не люблю. Впрочем, большинство пользователей не будут испытывать дискомфорта, так что пополнять список отрицательных отзывов пока не буду.

Займёмся осмотром системы охлаждения. Кулер WindForce 2X состоит из радиатора, пластикового кожуха и двух вентиляторов. Невольно сравнивая эстетику этой системы охлаждения с творением XFX, я сделал вывод, что последняя кажется мне куда более симпатичной. А вот с точки зрения эффективности, творение Gigabyte скорее всего окажется более эффективным. Алюминиевые рёбра радиатора пронизаны парой медных тепловых трубок диаметром 6 мм, трубки работают по технологии прямого контакта и закрывают большую часть GPU, чуть ниже вы увидите отпечаток трубок в термопасте. Если приглядеться к фотографиям, можно увидеть, что крыльчатка вентиляторов не параллельна плоскости радиатора, таким образом инженеры Gigabyte повысили эффективность отвода тепла, уменьшив эффект турбулентности. Кстати, используемые вентиляторы имеют диаметр 100 мм и это хорошо, плохо то, что они лишены тахометра, а значит наблюдать за скоростью вращения крыльчатки не получится.

На плате установлены чипы памяти, аналогичные тем, которые мы видели на плате XFX.

- Производитель – Elpida

- Суммарный объём составляет 1 Гбайт

- Тип памяти – GDDR-5

- Маркировка W1032BBBG -50-F

- Штатная эффективная частота составляет 5 ГГц (1,25 ГГц).

Производитель использовал следующие ШИМ контроллеры - NCP5395 и APW7165C , последний не поддерживает I2C протокол. Схема питания такова:

- 4 фазы для GPU

- По 1-ой фазе для памяти и PLL

Разгон, нагрев и уровень шума систем охлаждения.

В общем-то, приступая к разгону ускорителей Gigabyte GV-R785OC-1GD и XFX Radeon HD 7850 Core Edition, я столкнулся с одной мелкой неприятностью, которая, тем не менее, на некоторое время поставила меня в тупик и даже подтолкнула к мысли о том, что я начал стареть J.

Для начала я запустил утилиту MSI Afterburner, начал крутить ползунки настроек и всё бы ничего, вот только частотный потолок составил всего 1050 МГц. Такое ограничение накладывает AMD OverDrive, якобы для защиты от повреждения графического процессора. Так вот, старость я начал чувствовать, когда не нашёл кнопочек для снятия этого самого ограничения. Впрочем, вовремя пришёл в себя и достаточно быстро отыскал способ решения вопроса. Если вы, как и я, немного отстали от жизни, рассказываю.

- Можете скачать бета-версию утилиты

- MSI Afterburner 3.0.0 из нашего файлового архива. В настройках программы, в явном виде есть галочка, которая позволяет несколько сдвинуть частотный порог, в большую сторону, разумеется. В общем, в любой версии Afterburner можно полностью раскрыть потенциал видеокарты, для этого нужно в файле MSIAfterburner.cfg изменить конфигурацию по умолчанию на следующую:

UnofficialOverclockingEULA = I confirm that I am aware of unofficial overclocking limitations and fully understand that MSI will not provide me any support on it

UnofficialOverclockingMode = 1

для разблокировки напряжения и его мониторинга надо писать:

UnlockVoltageControl = 1

UnlockVoltageMonitoring = 1

- Второй способ практически аналогичен первому, с той лишь разницей, что для разблокировки частотного потенциала придётся использовать утилиту ASUS GPU Tweaking Tool, через GUI которой можно получить доступ к установкам напряжения и более высоких частот GPU.

Разумеется, есть и другие программы, однако в своих экспериментах я использовал эту парочку. Отмечу, что во время разгона скорость вращения крыльчатки вентиляторов СО выставлялась на максимум! Итогом моих стараний стали следующие результаты:

Стабильная частотная формула под нагрузкой при помощи утилиты MSI Kombustor для платы:

- XFX составила 1200 МГц для GPU и 5100 МГц для видеопамяти. Напряжение на GPU 1.2 В

- Gigabyte составила 1170 МГц для GPU и 5100 МГц для видеопамяти. Напряжение на GPU 1.2 Вю

К сожалению, в случае с платой Gigabyte, даже после разблокировки ползунка с частотой, максимальная планка для GPU составила те самые 1170 МГц. Отмечу, что после разгона ускорителя XFX, во время работы стресс-теста MSI Kombustor 2.5 был отчётливо слышен “стрекот” от элементов системы питания, в случае с платой Gigabyte таких проблем не наблюдалось.

Теперь поговорим об уровне шума и эффективности системы охлаждения при работе в обычном режиме. Система собрана в корпусе Cooler Master Cosmos 1000S, все штатные посадочные места заняты 120 мм вертушками со скоростью вращения 1200 об/мин. Во время тестов боковая стенка корпуса была открыта.

В процессе эксплуатации ускорителей, обе системы охлаждения проявили себя достойно. Кулер XFX в большинстве случаев никак не выделялся шумом на фоне остальных компонентов системы, разве только в играх, под серьёзной нагрузкой, шелест лопастей вентилятора выделялся на фоне системы, впрочем, до “пылесосов” из высшего сегмента этой вертушке ещё очень далеко. А вот кулер ускорителя Gigabyte вообще оказался молчуном. Никакого шума даже под нагрузкой. Конечно в бесшумной системе творение Gigabyte слышно будет, но в моём стенде СО этой видеокарты никак не выделяет себя.

Кстати, на графиках я привёл температурные показатели ускорителей XFX и Gigabyte после разгона. Сравнивать эти данные с теми, что были получены в обычных режимах, не корректно, поскольку скорость вращения вентиляторов видеокарты после разгона устанавливалась на максимальные обороты, тем не менее, для понимания общей ситуации эти данные не помешают.

Тестирование производительности. Выводы.

| Конфигурация тестового стенда MODLABS | |

| Системная плата | MSI 990FXA-GD80 – спасибо, MSI! |

| Центральный процессор | AMD FX-8150 @ 4400 МГц |

| Оперативная память | 16 Гбайт AMD Entertainment Memory @ 1600 МГц (9-9-9) |

| Видеокарта |

XFX Radeon HD 7850 Core Edition (860/4800) Gigabyte Radeon HD 7850 WindForce 2X (900/4800) |

| Жёсткие диски | 4x1 Тбайт Seagate ES.2 @ RAID0 |

| Операционная система | MS Windows 8 Professional x64 + upd |

| Версия драйверов видеокарты | 310.90 WHQL |

Тестирование видеокарт по одиночке я решил проводить на частоте 860 МГц, именно на такой частоте работает плата XFX, ровно на такой же частоте было проведено тестирование CrossFireX связки. Прибавка в 40 МГц в частоте ядра для решения Gigabyte практически никак не отразится на результатах, разница будет соответствовать максимум 5% и то, далеко не везде.

| Список тестовых приложений |

| Синтетические и полусинтетические тесты |

| 3DMark Vantage 1.1.0 (Performance, Extreme) |

| 3DMark 11 1.0.3.0 (Performance, Extreme) |

| Unigine Heaven 3.0 (Все детали и тесселляция установлены на максимум, 4xAA) |

| Игры |

|

Во всех играх рабочее разрешение было установлено в 1920x1080, все детали, доступные в опциях игры или в настройках бенчмарка были выставлены на максимум, в том числе и тесселляция, полноэкранное сглаживание устанавливалось в режим 4x во всех случаях, кроме Far Cry 3, где AA был равен 2x. Режим PhysX, если был доступен, включался в режиме максимального качества. В драйверах PhysX не выключался нигде, кроме 3DMark Vantage. Физические эффекты в играх включались на максимум, вне зависимости от поддержки со стороны графических ускорителей. |

| Metro 2033 DX11 |

| Batman Arkham City DX11 |

| Lost Planet 2 DX11 |

| Alien Versus Predator DX11 |

| S.T.A.L.K.E.R CoP DX11 |

| DIRT Showdown DX11 |

| Sleeping Dogs DX11 |

| Far Cry 3 DX11 |

| Hitman. Absolution |

| Asassin’s Creed III |

Выбирая конкурентов для наших участников, я ориентировался прежде всего на стоимость видеокарт в московской рознице. Прямого конкурента для Radeon HD 7850 в лагере NVIDIA, как мне кажется, нет. Средняя стоимость GeForce GTX 650 Ti примерно на 1000 рублей меньше, в то время как GeForce GTX 660 Ti на 2-3 тысячи дороже, чем Radeon HD 7850. В итоге, на графиках производительности оба эти ускорителя. Обращу ваше внимание на один момент. В списке тестовых пакетов у нас нынче пополнение, вот только не все карты остались на руках, поэтому в части программ отсутствуют результаты для графики NVIDIA, впрочем, общая картина всё равно видна. Оценивайте:

Итого.

Что касается баталии между Radeon HD 7850 и GeForce GTX 650 Ti, то первая практически всегда ведёт в счёте, проигрывая, только там, где используется ускорение физики через PhysX API, исполняемой в случае с картами Radeon силами CPU. Стоит ли эта победа ещё 1000 рублей – решать вам. Как по мне, так AMD подобрала стоимость для Radeon HD 7850 как нельзя лучше.

Ну а против GeForce GTX 660 Ti ускоритель Radeon HD 7850 уже не боец, только максимальный разгон позволяет догнать противника и то, далеко не везде. Более того, даже для CrossFireX бывают игровые исключения, которые не дают связке сильно обогнать GTX 660 Ti. На мой взгляд, такая ситуация связана с нехваткой локальной видеопамяти для работы в столь тяжёлых режимах. Мне кажется, что сейчас мы подошли к тому, что даже середнячки нуждаются в большом объёме VRAM и Radeon HD 7850 не исключение.

Масштабируемость в CrossFireX для Radeon HD 7850 сильно колеблется в зависимости от игры. Более старые проекты, вроде AvP, приносят двойной прирост, в то время как свежие игры, особенно в тяжёлых режимах, могут позволить поднять частоту смены кадров всего лишь на 20-40%, что не является хорошим результатом. В данном случае, опять-таки, я склоняюсь к теории о нехватке видеопамяти для эффективной работы.